¿Qué es Scrapear una página?

Scrapear una página es el proceso de obtener datos estructurados y específicos de una página web utilizando un código o programa. Esto se logra mediante la extracción de texto, imágenes, enlaces u otros elementos relevantes presentes en la página.

Scrapear una página es especialmente útil cuando se necesita recopilar información de múltiples páginas de manera automatizada. Por ejemplo, si se desea extraer información de productos de diferentes tiendas en línea, se puede utilizar el scraping para obtener los datos relevantes de cada página y luego consolidarlos en una base de datos.

Scrapear una página implica el uso de lenguajes de programación como Python, PHP o Ruby, así como bibliotecas y frameworks específicos como BeautifulSoup o Scrapy. Estas herramientas permiten acceder a la estructura HTML de una página web y extraer los elementos deseados utilizando técnicas como la búsqueda por etiquetas, atributos o patrones de texto.

Scrapear una página puede ser utilizado con diferentes propósitos, como el monitoreo de precios, seguimiento de noticias, recolección de datos para análisis o investigación, entre otros. Sin embargo, es importante tener en cuenta la legalidad y las restricciones impuestas por los propietarios del sitio web. Algunas páginas pueden tener políticas específicas que prohíben el scraping o limitan su uso de alguna manera.

Scrapear una página puede llevarse a cabo de forma manual, donde el programador inspecciona la estructura HTML de la página y escribe código personalizado para extraer los datos deseados. También existen herramientas y servicios en línea que simplifican el proceso de scraping, permitiendo a los usuarios especificar los elementos a extraer sin necesidad de escribir código.

En resumen, scrapear una página es el acto de extraer de forma automatizada y estructurada los datos de una página web utilizando un código o programa. Es una técnica útil para obtener información de múltiples fuentes y puede ser utilizado para diversos propósitos, siempre y cuando se respeten las políticas y restricciones legales de los sitios web visitados.

¿Qué es Scrapear webs?

Scrapear webs es una técnica utilizada en el campo de la programación para extraer de forma automatizada información de sitios web. Esta técnica consiste en recorrer una página web y extraer los datos necesarios para luego ser utilizados en diferentes aplicaciones.

El proceso de scrapear webs se realiza mediante la utilización de programas o scripts diseñados específicamente para este propósito. Estos programas se encargan de simular el comportamiento humano al navegar por una página web, accediendo a diferentes secciones y extrayendo la información requerida.

El objetivo principal de scrapear webs es obtener datos estructurados a partir de páginas web que no ofrecen una API o una forma directa de acceder a la información. Esto puede ser útil en diversas situaciones, como por ejemplo, la extracción de datos de una tienda online para realizar un análisis de precios o la recopilación de información de diferentes fuentes para llevar a cabo un estudio de mercado.

Para scrapear webs es necesario conocer el lenguaje HTML, que es el encargado de dar estructura y formato a las páginas web. Mediante el análisis del código HTML de una página, es posible identificar los elementos que contienen los datos que se desean extraer.

El scrapear webs puede ser una técnica muy útil, pero es importante tener en cuenta ciertas consideraciones legales y éticas al utilizarla. No todos los sitios web permiten el acceso y extracción automatizada de su contenido, por lo que es necesario verificar las políticas de cada página antes de utilizar esta técnica. Además, es importante evitar sobrecargar los servidores de los sitios que se están scraping, para evitar causar daños o perjudicar el funcionamiento normal de la página.

En resumen, el scrapear webs es una técnica utilizada para extraer de forma automatizada información de sitios web que no ofrecen una API o forma directa de acceso a sus datos. Esta técnica requiere conocimientos de HTML y es necesario tener en cuenta las consideraciones legales y éticas al utilizarla.

¿Cómo saber si puedo Scrapear una página web?

Scrapear una página web puede ser una tarea muy útil para extraer información o datos relevantes. Sin embargo, no todas las páginas permiten el scrapping y es importante saber si una página en particular puede ser scrapreada antes de intentarlo.

Para determinar si puedes scrapear una página web, hay diferentes aspectos que debes tener en cuenta. En primer lugar, debes verificar si la página tiene barreras de acceso o está protegida por algún tipo de autenticación, como un formulario de inicio de sesión. Si es así, es posible que no puedas acceder a la información de la página sin las credenciales adecuadas.

Otro aspecto a considerar es si la página utiliza alguna técnica de protección contra scrapers, como el bloqueo de direcciones IP o la detección de patrones de comportamiento sospechosos. Estas técnicas pueden hacer que sea imposible o difícil scrapear la página web.

Además, debes revisar los términos de servicio o las políticas de uso de la página web. Algunas páginas prohíben explícitamente el scrapping o restringen el acceso a su información. Si es el caso, es importante respetar estas políticas para evitar problemas legales.

Por último, es fundamental evaluar si el contenido que deseas scrapear está disponible en el código fuente de la página. Algunas páginas web utilizan tecnologías como JavaScript para cargar el contenido de forma dinámica, lo que puede dificultar el scrapping. En estos casos, puede ser necesario utilizar herramientas más avanzadas o técnicas de scrapping específicas.

En conclusión, antes de intentar scrapear una página web, es importante verificar si la página permite el acceso y extracción de su información. Al considerar aspectos como barreras de acceso, técnicas de protección, políticas de uso y disponibilidad del contenido en el código fuente, podrás determinar si puedes scrapear una página web o si es necesario buscar alternativas para obtener la información deseada.

¿Quién realiza el data scraping y con qué fin?

El data scraping es realizado por diferentes actores en la industria de la tecnología y la información. Uno de los principales protagonistas en esta práctica son las empresas de análisis de datos y consultoría. Estas empresas utilizan el data scraping para recopilar información relevante de diferentes fuentes en línea y luego analizarla para obtener insights y tomar decisiones estratégicas.

Otro grupo que realiza el data scraping son los desarrolladores y programadores. Ellos utilizan esta técnica para extraer información estructurada de distintas páginas web y alimentar sus propias aplicaciones y sistemas con estos datos.

Además, los investigadores y académicos también realizan el data scraping para estudiar diferentes fenómenos y analizar grandes volúmenes de datos. Esta práctica les permite obtener datos que de otra manera sería difícil o costoso recopilar de forma manual.

En cuanto al fin del data scraping, este puede variar dependiendo del contexto y los objetivos del usuario. Algunos utilizan esta técnica con fines comerciales, como mejorar la toma de decisiones en el ámbito empresarial o generar informes de mercado. Otros lo utilizan con fines académicos, para realizar investigaciones o analizar tendencias.

También hay quienes utilizan el data scraping para obtener información de competidores y así poder tomar medidas estratégicas en el ámbito empresarial. De igual manera, algunos hacen uso de esta técnica para recopilar información de interés general, como noticias o eventos, y compartirla con una audiencia específica.

En resumen, el data scraping es realizado por diferentes actores, como empresas de análisis de datos, desarrolladores, investigadores y académicos, con el fin de obtener información relevante y beneficiarse de ella en diferentes ámbitos, ya sea comercial, académico o estratégico.

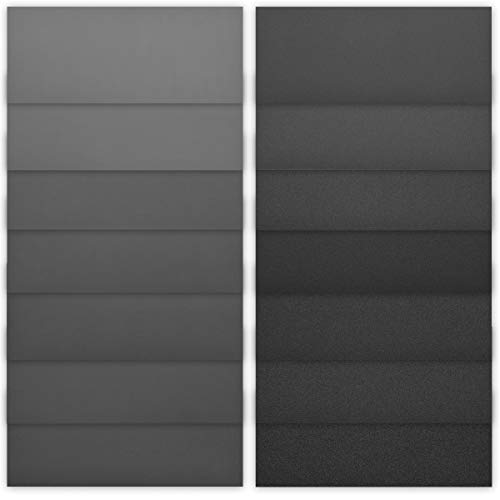

Papel Lija

Navaris Set de 42 papeles de lija - Para lijado en seco y húmedo - Lijas impermeables de granos del 120 a 3000 - Para casa y coche - 93 x 230 mm

- El juego perfecto: Con pliegos de diferentes granos, este set de papel de lija impermeable te ofrece una buena relación calidad-precio para proyectos grandes y pequeños.

- Casa o taller: Los granos van desde el 120 hasta el 3000, por lo que este paquete es adecuado para una amplia gama de trabajos de lijado fino y grueso en el hogar o en en trabajo.

- Para todo tipo de superficies: Utiliza las hojas abrasivas para lijar a mano superficies de alta resistencia, como piedra, madera, acero y otros metales, así como para pulir cerámica y madera.

- Multiusos: Podrás usar estas versátiles lijas impermeables en diferentes trabajos como manualidades, restauración de muebles, arreglos en la pintura del coche y más.

- Diferentes granos: Este completo set de papeles de lija incuye los siguientes granos: 120, 150, 180, 240, 320, 400, 600, 800, 1000, 1200, 1500, 2000, 2500 y 3000.

wolfcraft 3176000 - Rollo papel de lija abrasivo, grano 240, 5 m x 93 mm, plata

- Rollo de papel abrasivo para madera y metal

- Longitud de la banda abrasiva: 5 m

- Material abrasivo: corindón

- Fácil de usar

Papel de Lija para Madera Papel de Lija Fino Papel Abrasivo Uso en Seco y Húmedo, Grano 400, 600, 800,1000, 1200, 1500, 2000 Sandpaper para Muebles, Automotriz, Metal, Vidrio, Jade, Coche, Porcelanico

- El papel de lija está hecho de carburo de silicio, resistente al agua, apto para uso en seco y húmedo.

- Se puede usar papel de lija para pulir la superficie de madera, plástico, metal, baldosas de cerámica, etc. para que quede suave.

- Tamaño: 23 cm × 9,2 cm (9,05 × 3,62 pulgadas). Puedes cortar el papel de lija en otros tamaños que necesites.

- El paquete contiene # 400, # 600, # 800, # 1000, # 1200, # 1500, # 2000, 7 tipos de arena. 2 hojas de papel de lija para cada tipo de grano. Un total de 14 piezas de papel de lija.

- El papel de lija es adecuado para pulir y pulir finamente obras de arte, artesanías, automóviles, porcelana, muebles, vidrio, piedra, jade, cuero, etc.

Mesybveo 42 Piezas Papel de lija de Carburo de Silicio, Lija Madera Seco/al Agua Grano de 60 a 5000, 23 x 9 cm, para Pulir de Coche, Metal, Madera, Muro

- [Lo que obtendrá] Paquete contiene 42 hojas de tamaño de papel de lija: 23 * 9cm / 9 * 3,6 pulgadas, 3 hojas de cada tipo de grano, respectivamente 60 / 120 / 220 / 320 / 400 / 600 / 800 / 1000 / 1200 / 1500 / 2000 / 2500 / 3000 / 5000, el número de estilos suficientes para satisfacer sus diferentes necesidades

- [Material fiable] Lijas metal selección de material de carburo de silicio galvanoplastia, partículas finas y uniformes, mejor resistencia al agua, y se puede utilizar tanto en ambientes húmedos y secos, el uso de papel de cuero suave proporciona un ajuste perfecto con la mano, no es fácil de romper, doblar a voluntad sin perder la arena, la durabilidad del papel

- [Diseño seco y húmedo] Lija madera a mano se puede utilizar en ambiente seco o húmedo, si se utiliza demasiado fino durante mucho tiempo, con el fin de reducir la obstrucción, se puede añadir agua al uso, para prolongar la vida útil del papel de lija

- [Fácil de usar] El grano de papel de lija está impreso en la parte posterior, se puede ver fácilmente o encontrar el grano que desea, se puede cortar a cualquier tamaño que usted necesita, que es conveniente para su uso en diferentes escenarios

- [Amplia versatilidad] No sólo puede utilizar el papel de lija para lijar muebles de caoba, ámbar, metal, madera, paredes, sino también como regalo para sus amigos y parientes madereros

scraper

Amazon Basics - Rasqueta cortadora, de acero inoxidable, multiusos, 2,54 cm, Negro/Plateado

- Rasqueta cortadora multiusos para trabajar con masas, cortar y medir

- Hoja de acero inoxidable, ancha y rectangular con borde biselado

- Marcas de medida de 1 pulgada (2,54 cm) a lo largo del borde de la hoja para crear porciones perfectamente iguales

- Contorno cómodo, mango antideslizante, apto para lavavajillas para una limpieza fácil

- Contorno cómodo, mango antideslizante. Apta para lavavajillas para una limpieza fácil

Vicloon Raspador de Masa, 2 PCS de Plástico y 1 PC de Acero Inoxidable, Rasqueta Cortadora, Espátula para Hornear la Crema de Mantequilla, Pastele de Pan

- 🥨【3 IN 1 】--Juego de 3 piezas, 1 raspador de acero inoxidable, 2 raspadores de plástico (blanco y verde). El raspador de acero inoxidable mide 15 x 12 cm con Precise scale, el raspador de plástico de 12 x 9,5 cm.

- 🍠【Calidad premium】--El raspador de masa de plástico está hecho de plástico de calidad alimentaria, que es seguro y saludable para los alimentos, sin olor, impermeable y a prueba de aceite, se dobla y rebota sin deformación. El lavavajillas es seguro y fácil de limpiar.

- 🥞【DiseÑO Integrado】--Fácil de separar la masa sin que se pegue, los bordes del raspador de plástico son firmes y planos, la masa se divide fácilmente y el horneado es más agradable. Puede ayudarlo a cortar perfectamente pizza, masa, pan, mantequilla o pastel en trozos pequeños con Precise scale.

- 🥯【Forma Del Bol Grip】--Mango ergonómico y cómodo antideslizante. El raspador adopta un diseño trapezoidal semicircular, que se siente cómodo y no rayará sus manos. Adecuados tanto para profesionales como para panaderos novatos.

- 🧇【Herramienta Raspadora Multiusos】--El raspador de masa se puede usar para raspar la harina en la tabla de cortar y se puede usar para raspar los residuos sin rayar la superficie de la bandeja para hornear, paño antiadherente, etc.

STANLEY 0-28-217 - Rascavidrios con cuchilla retráctil, incluye 5 hojas de recambio

- Rascavidrios con diseño ergonómico de empuñadura bimaterial

- Cuchilla retráctil para mayor seguridad

- Cambio fácil de la hoja

- Longitud de la hoja es de 70mm

- Incluye: 5 hojas de recambio

STANLEY 0-28-206 - Espatula rascador multiusos

- Rasqueta en acero resistente al óxido

- Mango acabado en cabeza metálica

- Herramienta multiusos que puede sacar clavos, limpiar rodillos, abrir grietas, rascar, cortar y golpear

- Dimensiones del producto 22.2 x 7.7 x 2.7 cm